【部署指南】在基于英特尔锐炫™ 显卡及至强® W处理器的一体机平台上部署DeepSeek满血版模型

本部署指南虽然是围绕基于英特尔锐炫™ 显卡+至强® W处理器的一体机方案展开,且以DeepSeek-R1-Q4_K_M版为例,但该一体机方案也同时正在更多DeepSeek V3/R1版本上实施验。用户可以通过调整输入模型名称、参数,以及设定并行使用的显卡数量来进行调整。

基于数据安全、性能以及经济性等方面的考虑,拥有671B参数的满血版DeepSeek是企业用户开展DeepSeek本地化部署的首选。由英特尔锐炫™显卡与英特尔®架构处理器(特别是搭配至强® W处理器)组成的混合硬件平台,凭借其较为出色的成本优势及、更易于部署和实施优化以及拥有更稳定供应链等特点,为企业构建DeepSeek算力和加速基座提供了全新的、性价比更高的选择。目前,利用英特尔提供的IPEX-LLM开源工具库FlashMoE,用户已经可以充分使用CPU的AMX指令集和GPU的XMX指令集的异构算力,在该平台上轻松跑通满血DeepSeek的量化版(Q4_K_M)。

本文将详细介绍在Linux环境下,如何借助英特尔®架构处理器和多张英特尔锐炫™ 显卡的组合,通过IPEX-LLM工具库运行最新版llama.cpp Portable Zip包(无需手动安装),来实现该模型的部署与加速。

1、运行硬件要求

● 运行时的硬件要求为(更大的模型和其他精度可能需要更多的资源):

● 对于单块英特尔锐炫™ A770显卡的配置,用户需要在命令末尾添加选项-c 1024,来减少上下文长度(例如 1024),以避免OOM(内存溢出)。

● 对于4块英特尔锐炫™ A770显卡的配置,支持上下文长度为20k。

● 对于使用双路处理器的配置,建议在BIOS上开启子NUMA集群, 并在启动命令前增加numactl --interleave=all, 以获得更高的性能。

● 对于使用超线程的环境配置,建议设置环境变量命令:

export KMP_AFFINITY="granularity=fine,compact,1,0", 以获得更高的性能。

2. Linux 下运行快速入门

2.1 系统环境安装

查GPU驱动版本,建议更新至最新版本的驱动,下载链接:

Installing Client GPUs — Intel® software for general purpose GPU capabilities documentation

2.2 下载与解压

● 下载Linux版的 IPEX-LLM llama.cpp portable tgz包,下载链接:

https://github.com/intel/ipex-llm/releases/tag/v2.2.0-nightly

● 将tgz包解压至本地文件夹。

2.3 运行时配置

● 开启一个终端,输入以下命令进入解压缩后的文件夹:

cd /PATH/TO/EXTRACTED/FOLDER● 要使用英特尔GPU加速,在运行llama.cpp之前,需要设置如下环境变量:

export SYCL_CACHE_PERSISTENT=1● 对于Linux下使用多个GPU的场景,请参考本文4.2节了解如何进行多GPU配置。

2.4 运行GGUF模型

● 下载GGUF模型,至本地的当前目录,这里使用unsloth/DeepSeek-R1-GGUF的DeepSeek-R1-Q4_K_M.gguf,下载链接如下:

https://huggingface.co/unsloth/DeepSeek-R1-GGUF/tree/main/DeepSeek-R1-Q4_K_M

● 运行GGUF模型

在运行以下命令之前,请将/PATH/TO/ DeepSeek-R1-Q4_K_M-00001-of-00009.gguf更改为您的本地模型路径。

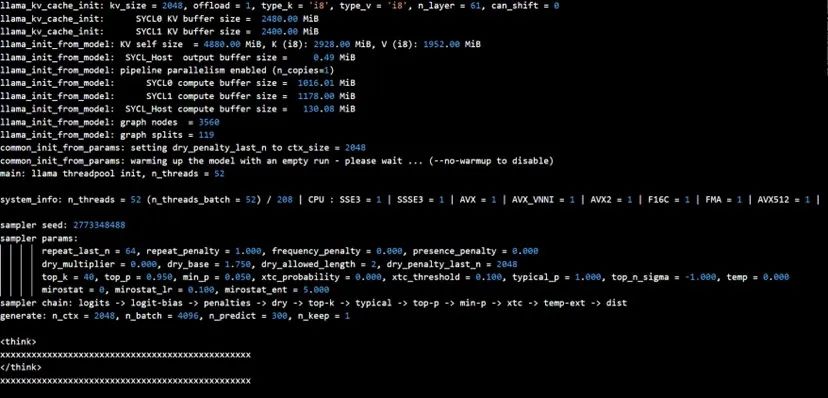

./llama-cli -m /PATH/TO/DeepSeek-R1-Q4_K_M-00001-of-00009.gguf -p "What's AI?" -n 2048 -ot exps=CPU -t 52 -e -ngl 99 --color -c 2500 --temp 0输出内容示意如下(单块英特尔锐炫™ A770显卡配置):

3、基于FlashMoE运行DeepSeek V3/R1

FlashMoE是一款基于llama.cpp构建的命令行工具,其针对DeepSeek V3/R1等混合专家模型(MoE)模型进行了优化。它整合了英特尔现有的AI加速技术(如处理器内置的AMX/AVX-512技术和GPU加速库),并可基于IPEX-LLM进一步释放CPU与GPU的异构协作能力,使用户能在较低的硬件成本下获得更高的推理吞吐量与更优的性能表现。这一方式目前可用于Linux平台,已经过测试验证的MoE GGUF模型包括(其他MoE模型同样也可支持):

● DeepSeek-V3-Q4_K_M

● DeepSeek-V3-Q6_K

● DeepSeek-R1-Q4_K_M

● DeepSeek-R1-Q6_K

● DeepSeek-V3-0324-Q4_K_M

● DeepSeek-V3-0324-Q6_K

运行GGUF模型

● 下载GGUF模型

至本地的当前目录,这里使用unsloth/DeepSeek-V3-0324-GGUF的DeepSeek-V3-0324-Q4_K_M-00001-of-00009.gguf,下载链接如下:

https://huggingface.co/unsloth/DeepSeek-V3-0324-GGUF/tree/main/Q4_K_M

● 运行 GGUF 模型

请将 /PATH/TO/ DeepSeek-V3-0324-Q4_K_M-00001-of-00009.gguf更改为您的本地模型路径,然后运行DeepSeek-V3-0324-Q4_K_M-00001-of-00009.gguf。

./flash-moe -m /PATH/TO/DeepSeek-V3-0324-Q4_K_M-00001-of-00009.gguf --prompt "What's AI?"输出内容示意如下(2块英特尔锐炫™ A770显卡配置):

4、使用技巧与故障排除

4.1 错误:检测到不同的sycl设备

● 如果在运行中看到如下的错误日志:

● 这一错误的产生是由于GPU产品的规格不同,任务会根据设备的显存进行分配。图中作为集成显卡的iGPU(Intel UHD Graphics 770)由于能获得更大的系统共享显存(64GB),因此将承担2/3的计算任务,导致性能表现较差,因此任务会在检查时报错。

用户可以有以下两种选择:

1) 禁用iGPU可以获得最佳性能,更多详情可以访问本文4.2部分内容。

2) 禁用此检查并使用所有GPU,可以运行以下命令:

export SYCL_DEVICE_CHECK=04.2 多GPU配置

● 如果平台中有多个英特尔GPU产品,llama.cpp默认会在所有GPU上运行。如果用户不清楚硬件配置,可以在运行GGUF模型时获取相关配置信息。例如:

● 要指定llama.cpp使用的英特尔GPU产品,可以在启动llama.cpp命令之前设置环境变量ONEAPI_DEVICE_SELECTOR,命令如下:

export ONEAPI_DEVICE_SELECTOR=level_zero:0 (如果你希望在单张GPU上运行,请设置此环境变量,llama.cpp将使用第一块GPU。)export ONEAPI_DEVICE_SELECTOR="level_zero:0;level_zero:1" (如果你希望在多张GPU上运行,请设置此环境变量,llama.cpp将使用第一和第二块GPU。)

4.3 性能环境

● 环境变量SYCL_PI_LEVEL_ZERO_USE_IMMEDIATE_COMMANDLISTS用于控制是否使用即时命令列表将任务提交到GPU。启动此变量通常可以提高升性能,但也有例外情况。因此,建议用户在启用和禁用该环境变量的情况下进行测试,以找到最佳的性能设置。用户可以使用以下命令来启用该命令:

export SYCL_PI_LEVEL_ZERO_USE_IMMEDIATE_COMMANDLISTS=1关于性能环境的更多信息,可参考以下链接:

初步的性能验证表明,在单路至强® W处理器加2-4块英特尔锐炫™A770显卡配置下,本文所述方案可以获得接近10 Token/s 的性能表现,已能满足企业级生成式AI,例如离线语音助手、文档摘要等应用场景的需求。

结语

本部署指南虽然是围绕基于英特尔锐炫™ 显卡+至强® W处理器的一体机方案展开,且以DeepSeek-R1-Q4_K_M版为例,但该一体机方案也同时正在更多DeepSeek V3/R1版本上实施验。用户可以通过调整输入模型名称、参数,以及设定并行使用的显卡数量来进行调整。

基于英特尔锐炫™ 显卡 + 英特尔® 至强® W处理器的一体机平台,旨在以更低的成本和更便捷的方式,帮助用户实现DeepSeek-R1-671B等千亿级参数大模型的高效部署。该平台不仅可借助英特尔锐炫™ 显卡提升任务与服务的并发能力,还可以通过最新版KTransformer或FlashMOE,来调动至强® W处理器的内置AMX加速技术,以实现更高效的CPU与GPU异构加速方案。同时,其高度集成的软硬一体模式不仅满足了长上下文推理需求,还实现了能耗与成本的可控性,为AI服务规模化落地提供了可靠且易用的基础设施支撑。此外,它还能更好地响应近期用户在 DeepSeek 或其他开源大模型实践中的迫切需求,提供更高灵活性、更贴近业务环境的部署方式、更快速的响应速度,并在数据安全与隐私保护方面具备先天优势。

更多推荐

已为社区贡献272条内容

已为社区贡献272条内容

所有评论(0)